[사이다] ① AI 간에 지식 이전 기술 개발

2026년 01월 29일 오전 09:00

[기자]

한 주간 주목할 만한 사이언스 이슈를 다 모아온 권석화 입니다.

지금까지는 인공지능의 새 모델이 나올 때마다 다시 처음부터 학습을 시켜야 했는데요.

국내 연구진이 이런 비효율을 줄일 수 있는 기술을 개발했습니다.

영상 보시죠.

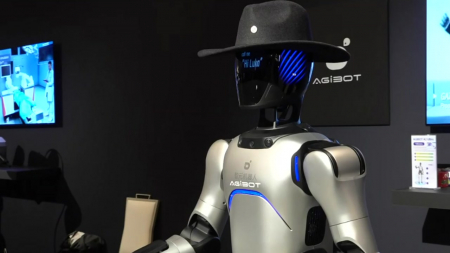

최근 대규모 이미지와 언어 데이터로 사전 학습된 '시각–언어 모델'이 많이 활용되고 있는데요.

적은 양의 데이터만으로도 다양한 분야에 빠르게 적응할 수 있다는 장점이 있지만 새 모델이 나오면 처음부터 다시 학습을 시키는 번거로움이 있었습니다.

이에 국내 연구팀이 서로 다른 인공지능 모델 사이에서 학습된 지식을 그대로 이식하는 기술을 설계했습니다.

이번 기술의 핵심은 AI의 복잡한 내부 구조를 바꾸지 않는다는 점인데요.

서로 구조가 전혀 다른 인공지능이라도 같은 질문에 어떤 답을 내놓았는지만 보고 그 결과를 기준으로 노하우를 정리해 전달합니다.

이 과정에서 다시 처음부터 학습시키는 복잡한 역전파 과정이 필요 없기 때문에 연산량은 물론, 시간과 비용도 크게 줄일 수 있다고 하는데요.

연구진 설명, 직접 들어보시죠.

[김 현 우 / KAIST 전산학부 교수 : "오류를 최소화시키기 위해서 학습하는 과정에 역전파를 사용하면 비용이 많이 드는데 저희는 간단한 전이 가능한 적응 지식을 상위 레이어에서만 조금 새로운 네트워크에 새로운 인공신경망에 잘 붙을 수 있도록 간단한 트랜스포 선형 변환을 시키는 방법만을 적용했기 때문에…."]

연구진은 이렇게 기존에 쌓아둔 전문 지식을 패치하듯 이어 붙이는 방법을 앞으로 더 큰 규모의 모델로 확장해 나갈 계획이라고 밝혔는데요.

새로운 인공지능 모델이 등장하더라도 기존에 쌓아온 지식을 빠르게 이어서 활용할 수 있을 것으로 기대되네요.

YTN 사이언스 권석화 (stoneflower@ytn.co.kr)

한 주간 주목할 만한 사이언스 이슈를 다 모아온 권석화 입니다.

지금까지는 인공지능의 새 모델이 나올 때마다 다시 처음부터 학습을 시켜야 했는데요.

국내 연구진이 이런 비효율을 줄일 수 있는 기술을 개발했습니다.

영상 보시죠.

최근 대규모 이미지와 언어 데이터로 사전 학습된 '시각–언어 모델'이 많이 활용되고 있는데요.

적은 양의 데이터만으로도 다양한 분야에 빠르게 적응할 수 있다는 장점이 있지만 새 모델이 나오면 처음부터 다시 학습을 시키는 번거로움이 있었습니다.

이에 국내 연구팀이 서로 다른 인공지능 모델 사이에서 학습된 지식을 그대로 이식하는 기술을 설계했습니다.

이번 기술의 핵심은 AI의 복잡한 내부 구조를 바꾸지 않는다는 점인데요.

서로 구조가 전혀 다른 인공지능이라도 같은 질문에 어떤 답을 내놓았는지만 보고 그 결과를 기준으로 노하우를 정리해 전달합니다.

이 과정에서 다시 처음부터 학습시키는 복잡한 역전파 과정이 필요 없기 때문에 연산량은 물론, 시간과 비용도 크게 줄일 수 있다고 하는데요.

연구진 설명, 직접 들어보시죠.

[김 현 우 / KAIST 전산학부 교수 : "오류를 최소화시키기 위해서 학습하는 과정에 역전파를 사용하면 비용이 많이 드는데 저희는 간단한 전이 가능한 적응 지식을 상위 레이어에서만 조금 새로운 네트워크에 새로운 인공신경망에 잘 붙을 수 있도록 간단한 트랜스포 선형 변환을 시키는 방법만을 적용했기 때문에…."]

연구진은 이렇게 기존에 쌓아둔 전문 지식을 패치하듯 이어 붙이는 방법을 앞으로 더 큰 규모의 모델로 확장해 나갈 계획이라고 밝혔는데요.

새로운 인공지능 모델이 등장하더라도 기존에 쌓아온 지식을 빠르게 이어서 활용할 수 있을 것으로 기대되네요.

YTN 사이언스 권석화 (stoneflower@ytn.co.kr)

[저작권자(c) YTN science 무단전재, 재배포 및 AI 데이터 활용 금지]